von Tobias Rebholz

Eine qualitativ hochwertige inhaltliche Erschließung mit dem hauseigenen Fachvokabular des Standard-Thesaurus Wirtschaft (STW) bildet das Fundament für eine erfolgreiche Recherche nach wirtschaftswissenschaftlichen Informationen in den Recherchesystemen der ZBW – Leibniz Informationszentrum Wirtschaft. Die Erschließung mit STW-Vokabular dient dazu, dass bei Suchanfragen alle relevanten Titel im Suchergebnis berücksichtigt werden.

Damit ein kontrolliertes Fachvokabular wie der STW seine Aufgaben langfristig erfüllen kann, ist eine kontinuierliche inhaltliche Weiterentwicklung elementar. An diesem Punkt setzte dieses MALIS-Projekt (Betreuer: Peter Kostädt) an; im Rahmen des Projektes wurden Ansätze herausgearbeitet, die es ermöglichen, computergestützt neue Terme für eine Erweiterung des STW zu ermitteln.

Der Standard-Thesaurus Wirtschaft wurde unter Förderung des Bundesministeriums für Wirtschaft (BMWi) in den 1990er Jahren in Zusammenarbeit mit dem HWWA (jetzt ZBW), GBI/GENIOS und dem ifo Institut entwickelt und wird von den Konsortialpartnern seitdem zur Indexierung eingesetzt.

Bereits in der Vergangenheit wurde der STW regelmäßig an die gängige Wirtschaftsterminologie angepasst und thematisch weiterentwickelt. Nach einer mehrjährigen, 2015 abgeschlossenen Komplettüberarbeitung bildet der STW als wirtschaftswissenschaftliches Fachvokabular den aktuellen Sprachgebrauch in dem Fachgebiet ab und ist die terminologische Basis für eine fachspezifische Inhaltserschließung der hauseigenen ZBW-Bestände. Um diesen Status auch zukünftig dauerhaft garantieren zu können, wird es auch in Zukunft erforderlich sein, den STW kontinuierlich weiterzuentwickeln und an die veränderten Gegebenheiten in dem Wirtschaftswissenschaften anzupassen.

Allerdings ist in der heutigen Zeit ein rein manuelles Erkennen relevanter Thesaurus-Kandidatenterme mit Blick auf maschinelle Textmining-Verfahren nicht mehr zielführend und praktikabel. Insbesondere vor dem Hintergrund der Neuausrichtung der ZBW zu einer forschungsbasierten Informationsinfrastruktureinrichtung mit den Forschungsschwerpunkten Medieninformatik, Web Science und Knowledge Discovery, ist es naheliegend auch im Bereich der Thesaurus-Entwicklung auf unterstützende informationstechnische Verfahren zu setzen.

Im Rahmen des Projektes galt es herauszufinden, wie man computergestützt neue Kandidaten-Terme für die Erweiterung des STW aus vorhandenen Metadaten ermitteln kann, ohne dafür auf aufwändige Textmining-Verfahren zurückzugreifen.

Die Grundidee einer computergestützten Thesaurus-Erweiterung basierte auf vorangegangenen Überlegungen zur automatischen Abbildung von STW-Deskriptoren auf Autoren-Keywords, ein Verfahren, welches die ZBW zukünftig zur Homogenisierung ihrer Sacherschließung einzusetzen gedenkt.

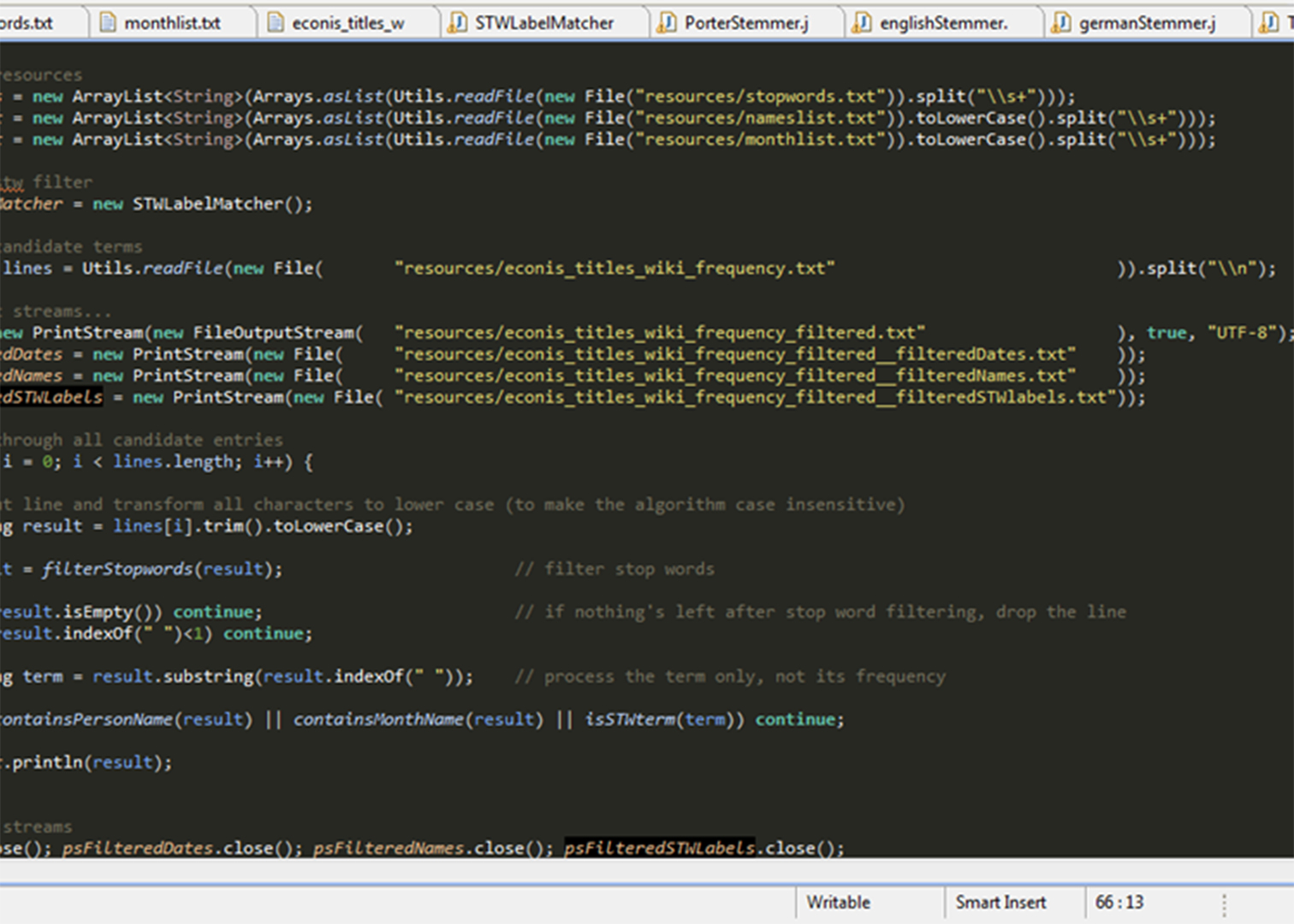

Die Datenquelle für die Ermittlung von STW-Kandidatentermen waren Titeldaten aus dem ZBW-eigenen Online-Katalog ECONIS. Für die Kandidatenfilterung wurden hier von Kollegen des Forschungsbereiches Knowledge Discovery positive STW-Terme ermittelt und entfernt. Nach diesem Schritt blieben in den Titeln Wörter übrig, die nicht in der eingebundenen STW-Version zu finden sind. Zur Ermittlung sinntragender Worte des Resttitels wurde im nächsten Schritt ein Abzug aller deutsch- und englischsprachigen Wikipedia-Einträge herangezogen und dieser mit den Restwörtern in den Titeldaten abgeglichen.

Alle gefunden Kandidaten-Terme wurden in eine Liste geschrieben und nach Frequenz in den Titeldaten sortiert. Auf diese Weise konnten mehr als 200000 Wikipedia-Terme in den Titeldaten ermittelt werden.

Anders als bei Autoren-Keywords handelte es sich hierbei allerdings nicht ausschließlich um ökonomische Terminologie und bedurfte zusätzlicher Filterungsprozesse.

Die grobe qualitative Analyse der Zwischenergebnisse zeigte auf, dass die Liste eine Mischung aus verschiedenen Formen von Eigennamen (Personennamen, Ortsnamen und Institutionsnamen) enthält, wie auch Adverbien oder Adjektive oder Daten in Form von Jahreszahlen. Da für die STW-Erweiterung eindeutige fachspezifische Terme als Deskriptoren oder Nichtdeskriptoren in Frage kommen, wurde für die Nachbearbeitung der Liste ein mehrstufiges Filterverfahren entworfen.

Für die Entwicklung der Filter erfolgte darauffolgend eine tiefergehende Auswertung der Liste. Ziel war es, die anfängliche Liste mit Filtern um 2/3 des ursprünglichen Umfangs zu reduzieren. Bei der fachlichen Auswertung zeigte sich, dass es sich bei einem Großteil der Terme, wie bereits angenommen, um sehr allgemeine nicht fachspezifische Begriffe oder ambige Terme handelte. Um diese zu filtern, wurde die Liste zunächst um Stoppwörter bereinigt. Anschließend wurden alle aus nur einem Wort bestehenden Wikipedia-Begriffe sowie Monats- und Personennamen entfernt. Hierzu konnten u.a. umfangreiche Namens- und Stoppwortlisten aus dem Internet herangezogen werden. Für diesen Abgleich wurde von einem am Projekt beteiligten Mitarteiter ein Programm in Java geschrieben, welches die verschiedenen Filterlisten berücksichtigt und eine bereinigte Liste generiert, die insgesamt 63234 Kandidatenterme umfasste.

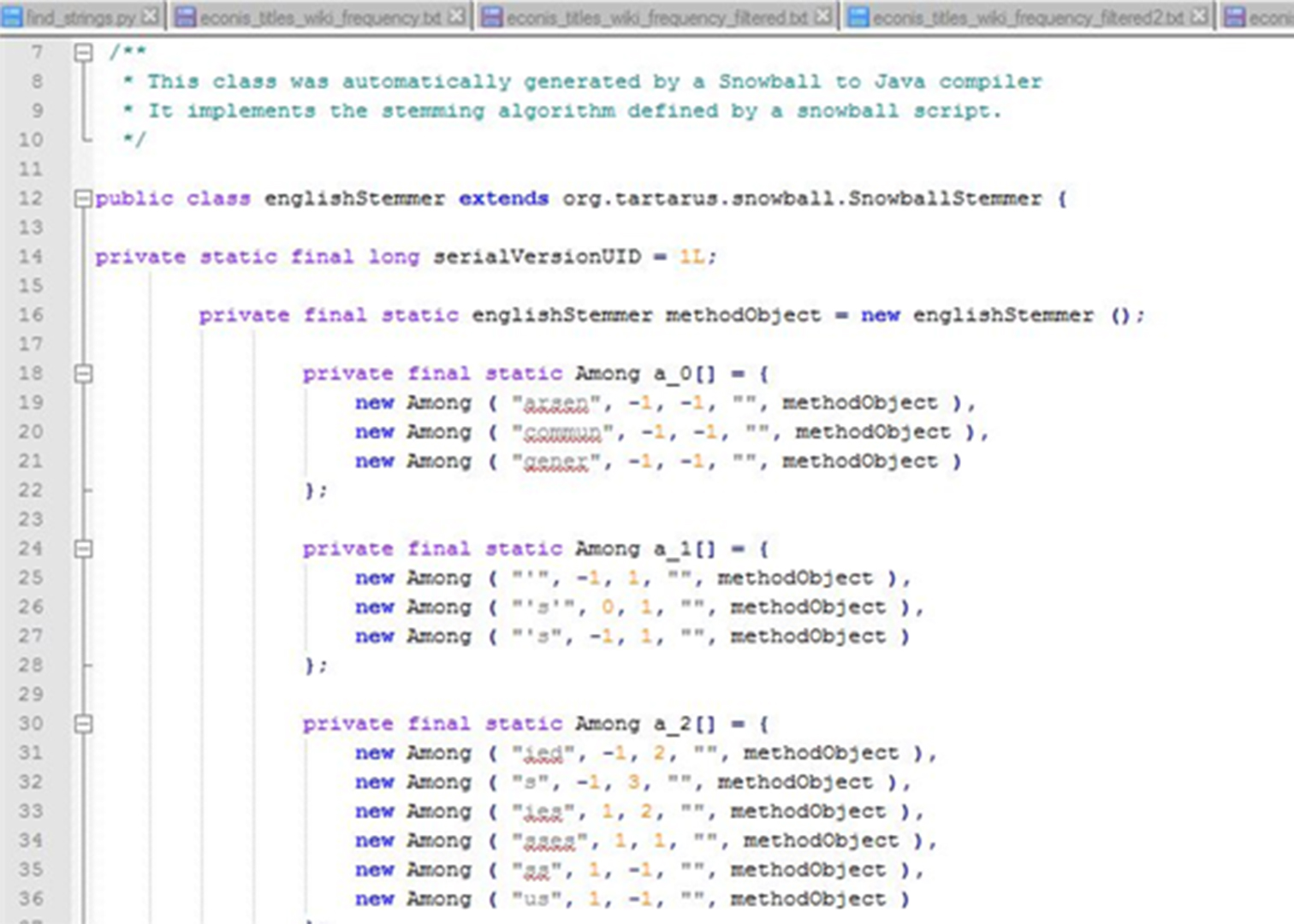

Bei der anschließenden Auswertung der gefilterten Liste fiel der Fokus auf Kandidaten mit Pluralformen. Hier präsentierte sich, dass es sich bei vielen Phrasen um die Pluralformen von STW-Termen handelte. Dies führte zu dem Schluss, dass im Rahmen der ursprünglichen Kandidatengenerierung nicht alle STW-Terme entfernt wurden. Um die STW-Terme nachträglich zu ausstreichen, wurden die 63234 Kandidatenterme nochmals mit einer modifizierten Liste der STW-Begriffe abgeglichen. Vorab wurden sowohl die STW-Begriffe als auch die Kandidaten-Terme einem Stemming unterzogen. Als Basis diente hier der Porter-Stemmer-Algorithmus auf Basis des Snowball-Frameworks.

Durch die Stammformreduktion der STW- und Kandidaten-Terme konnte bei einem danach angestoßenen Abgleich beider modifizierter Listen die Anzahl der Kandidaten nochmals signifikant reduziert werden. In einem letzten Schritt wurden alle Terme entfernt, die weniger als 20 Mal in den Titeldaten auftauchten. Durch diese Maßnahme schrumpfte die Liste auf genau 1700 Einträge, eine Anzahl von Termen, die auch für eine Redaktion intellektuell zu bewerten ist.

Abschließend ist festzuhalten, dass es ein einfaches Verfahren gibt, welches Kandidaten-Terme für eine Thesaurus-Erweiterung liefert. Da die eingesetzten Methoden nur eine grobe Filterung erlauben und die Güte des Verfahrens im Rahmen des Projektes nicht bestimmt werden konnte, sollte nach persönlicher Einschätzung diese Form der Kandidatengenerierung nur einen Teil eines Verfahrens darstellen. Inwiefern dieses Verfahren das Terminologie-Management in der ZBW unterstützen kann, wird sich im Laufe der Zeit zeigen.